Entendendo Tokens no ChatGPT: O que são, como calcular e como isso afeta seus custos com IA

Publicado em 13/06/2025 às 17h37, por: Rodrigo Neves

Talvez você já esteja usando o ChatGPT em algum projeto, ou esteja testando soluções baseadas em inteligência artificial. Mas existe uma métrica silenciosa que determina o quanto isso realmente custa: os tokens. E entender o que são e como calculá-los é essencial para otimizar custos, prever consumo e escalar com segurança.

O que são tokens?

Tokens são as unidades mínimas que o ChatGPT utiliza para processar e gerar textos. Ao contrário de nós, humanos, que lemos frases inteiras, a IA entende linguagem dividindo-a em pequenos fragmentos — e são esses fragmentos que ela “cobra” para interpretar e responder.

Um token pode ser:

- Uma palavra inteira:

estratégia - Uma parte de uma palavra:

estra,tégia - Um símbolo de pontuação:

?,!,, - Um número:

2025 - Um espaço em branco:

" "

Na prática, a IA quebra todo o conteúdo em unidades que fazem sentido computacionalmente.

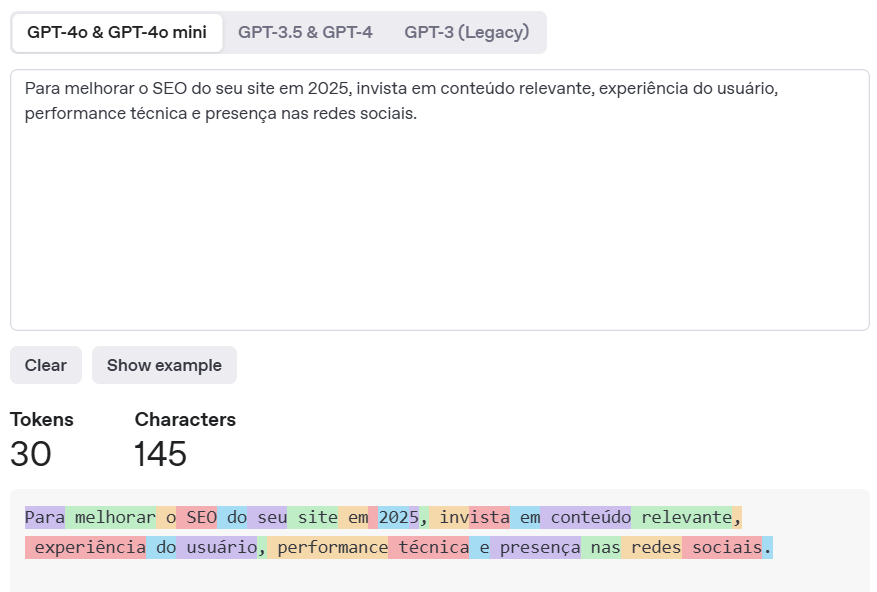

Exemplo prático com tokens

Vamos supor que sua aplicação esteja usando o seguinte texto para enviar uma pergunta ao ChatGPT:

“Como posso melhorar o SEO do meu site e atrair mais tráfego orgânico em 2025?”

Essa frase possui 21 tokens, segundo o tokenizador oficial da OpenAI.

Agora imagine que a resposta do modelo venha assim:

“Para melhorar o SEO do seu site em 2025, invista em conteúdo relevante, experiência do usuário, performance técnica e presença nas redes sociais.”

Essa resposta tem 30 tokens.

Total da interação: 51 tokens.

Agora multiplique isso por milhares de interações diárias.

Como isso impacta seu custo?

Cada token tem um valor em dólar. Por exemplo, com os preços da OpenAI (modelos GPT-4 e GPT-3.5):

Tabela de cálculo de custo por 51 tokens (21 de entrada + 30 de saída)

Valores estimados com base na tabela pública da OpenAI (jun/2025)

Custo calculado proporcional a 1.000 tokens

| Modelo | Custo por 1K tokens (entrada + saída) | Custo estimado por 51 tokens |

|---|---|---|

| GPT-3.5 Turbo | US$ 0.0005 + US$ 0.0015 | US$ 0.000102 |

| GPT-4 | US$ 0.03 + US$ 0.06 | US$ 0.00306 |

| GPT-4 Turbo | US$ 0.01 + US$ 0.03 | US$ 0.00102 |

| GPT-4o | US$ 0.005 + US$ 0.015 | US$ 0.00051 |

💡 Observação: Os custos são divididos entre input e output, portanto 21 tokens contam como entrada e 30 como saída.

Como testar quantos tokens seu conteúdo consome?

Utilize o Tokenizer oficial da OpenAI:

🔗 https://platform.openai.com/tokenizer

Você cola seu texto e imediatamente visualiza a contagem exata de tokens. Ideal para:

- Validar prompts antes da produção

- Simular respostas

- Estimar custos de uso real da API

Dicas para reduzir consumo de tokens:

- Use mensagens mais objetivas

- Evite históricos longos nas conversas quando não forem necessários

- Implemente compactação de dados (resumos ou extrações)

- Limite a resposta gerada com o parâmetro

max_tokensna API - Crie fluxos de prompts mais enxutos, sem redundância

Tokens são a métrica invisível que sustenta toda a lógica de precificação das IAs generativas. Ignorar esse detalhe pode significar surpresas na fatura no fim do mês — ou inviabilizar a escalabilidade de uma solução.

Antes de desenvolver qualquer aplicação com IA, comece entendendo o comportamento de tokens. Teste, simule, otimize. E sempre utilize o Tokenizer da OpenAI como ferramenta estratégica de validação.

pt

pt  en

en  es

es

.comentários